L'IA démystifiée : au-delà du storytelling

Pourquoi “GPT” n’est pas synonyme d’intelligence, et pourquoi le dire, ce n’est pas être snob.

L’IA a cessé d’être un sujet technique. C’est devenu un mot de pouvoir, une balise LinkedIn, un argument de vente, une ancre de storytelling.

Alors reprenons.

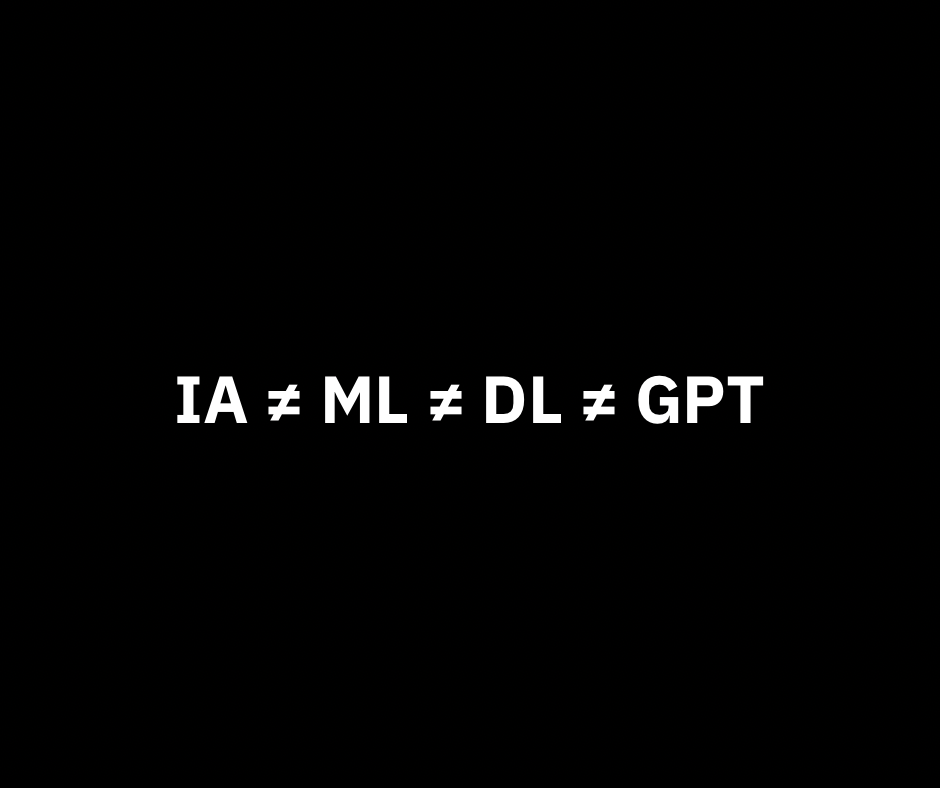

🤖 IA ≠ ML ≠ DL ≠ GPT

Oui, les sigles fatiguent, mais les confondre, c’est se tirer une balle dans le pipeline.

-

IA (Intelligence Artificielle)

Champ global. Objectif : créer des systèmes capables de comportements “intelligents”. Pas toujours statistique, parfois symbolique; et même des fois les deux. -

ML (Machine Learning)

Sous-ensemble de l’IA. Des modèles qui apprennent à partir de données.

Pas de règle imposée, mais des patterns extraits. -

DL (Deep Learning)

Sous-ensemble du ML. Réseaux de neurones profonds.

Des architectures capables d’extraire automatiquement des représentations complexes. Plus de couches ≠ plus d’intelligence; mais définitivement plus de puissance. -

GPT

Un type de LLM (Large Language Model) basé sur l’architecture Transformer.

Un modèle de complétion : il ne “pense” pas, il devine le mot suivant.

Tous les GPT sont des LLM, mais tous les LLM ne sont pas des GPT. Un peu comme tous les rectangles sont des quadrilatères; sauf que les GPT, eux, veulent ton job.

🛠 Un modèle ≠ une solution

Un modèle est un outil, un système d’approximation.Il produit des sorties plausibles, mais pas nécessairement vraies.

Sans données propres, tâche définie, ou validation rigoureuse,

GPT devient un générateur de confettis statistiques.

Comme une pluie de confettis : joyeux, coloré… et ça ne colmate pas la fuite. ✨

🔄 Transformer : lecture parallèle, pas lecture divine

L’architecture Transformer (2017) est une avancée remarquable, pas un miracle. Qui sert l'optimisation de la parallélisation, et la gestion affinée du contexte.

Imagine une bibliothèque qui se souvient mieux des phrases précédentes, qui lit en diagonale sans comprendre l’histoire.

📦 LexiQue Tech — Extrait du jour

Ce que croient les marketeux IA : Un robot géant qui sauve la planète avec un prompt. Explosion à chaque token.

Ce que c’est vraiment : Un modèle basé sur l’attention, capable de traiter le texte en parallèle. Le transformer lit tout et retient ce qui l’arrange. Comme ton manager.

💣 Punchline : Le transformer ne comprend pas. Il pèse l’importance, puis te sort une suite de mots parfaitement plausible.

🎯 Finalité

Tu veux piloter ces outils ? Pas besoin de calcul différentiel.

Mais souviens-toi :

- 🧮 Il y a 96 couches de matrices, de fonctions d’activation et de descentes de gradient.

- 👨💻 Il y a une armée de chercheurs et d’annotateurs sous-payés derrière chaque dataset.

- 🧪 Il y a une complexité qui mérite un minimum de respect.

❗ Si tu as survécu sans frissonner, ose franchir la porte d'une vérité plus sombre de Root Access v0.1 👁🗨